NVIDIA, Blackwell B200 GPU ile yapay zekâ bilişiminde çığır açıyor. Bu GPU, veri merkezlerini tek bir “Yapay Zeka Fabrikası” olarak yeniden tanımlıyor. Trilyon parametreli modelleri daha verimli şekilde eğitmeye ve çalıştırmaya olanak sağlıyor. Ayrıca, B200, H100 ve H200 GPU’lara göre eğitim ve çıkarım performansında ciddi sıçramalar sunuyor.

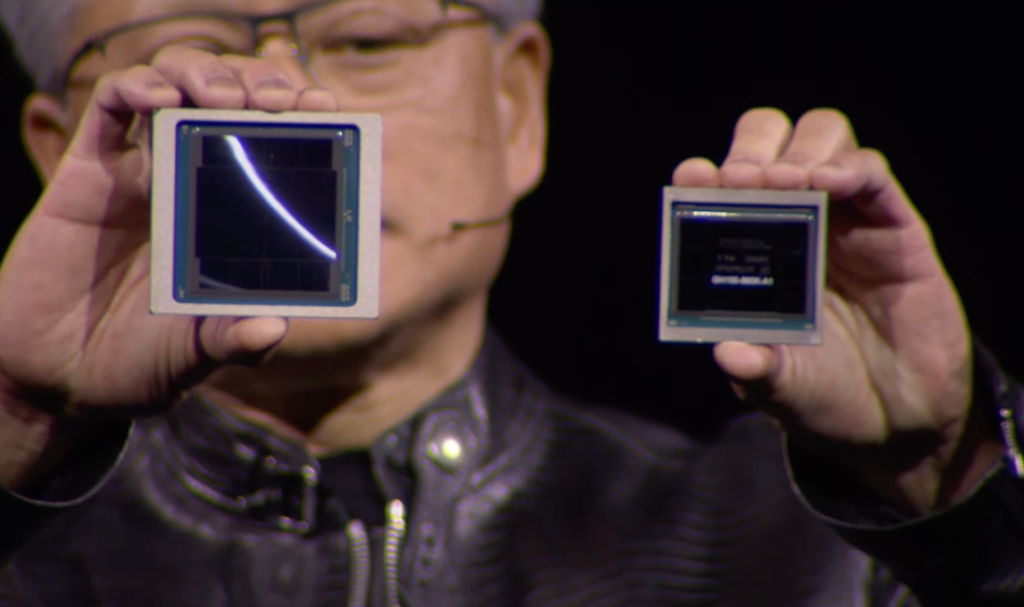

Nvidia CEO’su Jensen Huang, GTC canlı yayınında sol tarafta yeni GPU’sunu, sağ tarafta ise H100’ü gösteriyor.

Blackwell B200’ün Mimari Yenilikleri

Blackwell, çift kalıplı tasarımıyla retikül sınırını aşıyor. Her kalıp, TSMC 4NP süreciyle üretiliyor. NV-HBI bağlantısı ile 10 TB/s hızında veri alışverişi yapıyor. Bu tasarım, GPU’yu tek bir birim gibi çalıştırıyor ve performans cezalarını önlüyor. Buna ek olarak, B200, 192 GB HBM3e bellek ve 8 TB/s bant genişliği sunuyor. Bu sayede büyük modeller daha az GPU ile çalışıyor ve düğümler arası iletişim ihtiyacı azalıyor.

Temel Teknolojik Yenilikler

- Nesil Transformer Motoru, FP4 ve FP6 formatlarını kullanıyor. Bu motor, mikro-tensör ölçeklendirme ile düşük hassasiyette çalışırken doğruluğu koruyor. 5. nesil NVLink ve NVSwitch dokusu, GPU’ları yüksek hızda birbirine bağlıyor. Büyük ölçekli modellerde darboğazları ortadan kaldırıyor. SHARP motorları ağ içi hesaplamaları optimize ediyor ve veri trafiğini azaltıyor.

Blackwell ayrıca RAS motoru ve Güvenli Yapay Zeka (TEE) sistemi içeriyor. Bu özellikler, uzun süreli eğitim ve çıkarım iş yüklerinde güvenilirliği artırıyor. Sıkıştırma çözme motoru ise verileri CPU yerine GPU’da saniyede 800 GB/s’ye kadar işliyor. Bu sayede iş akışları hızlanıyor.

Nvidia, Blackwell ile hem FP4’ü hem de FP6’yı ekleyeceğini söylüyor.

Performans Avantajları

MLPerf testleri, B200’ün H100’e kıyasla eğitimde 2.2 kat daha hızlı olduğunu gösteriyor. Çıkarımda ise 3 ila 30 kat artış sağlıyor. Ayrıca, token başına maliyet önemli ölçüde azalıyor. B200, bilgisayarlı görü ve HPC iş yüklerinde genellikle H100 ve AMD MI300X’in önünde yer alıyor. Bu durum, FP4 destekli Transformer Motoru ve geniş bellek bant genişliği sayesinde mümkün oluyor.

Blackwell Ekosistemi ve Dağıtım

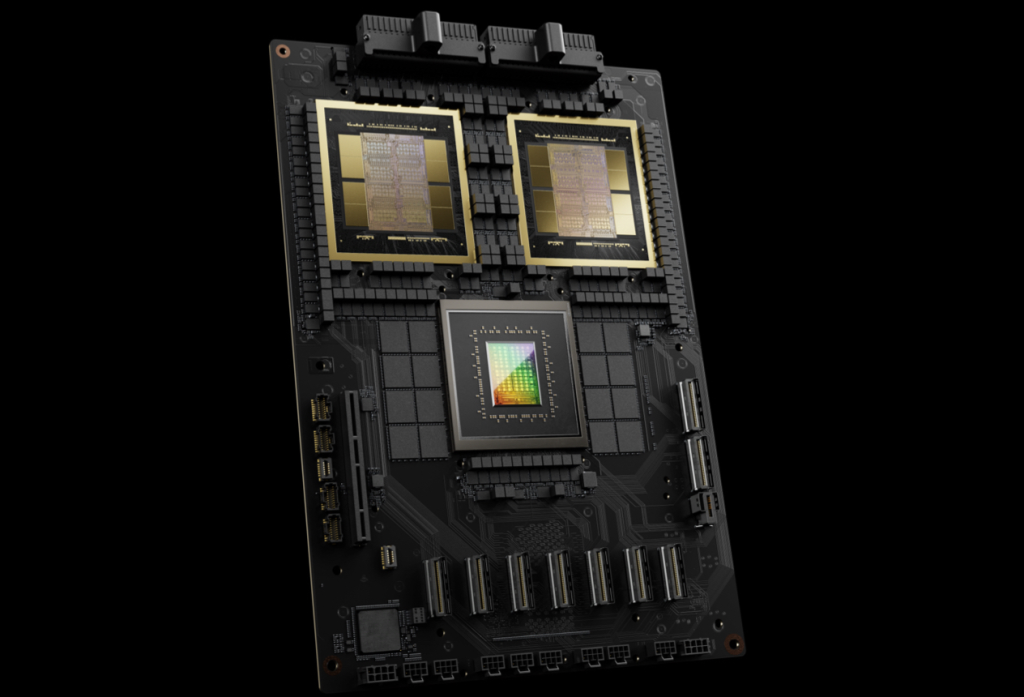

GB200 Grace Blackwell Süperçipi, iki B200 GPU ve 72 çekirdekli Grace CPU içeriyor. NVLink-C2C bağlantısı ile CPU ve GPU’lar arasında birleşik bellek alanı oluşturuyor. HGX/DGX B200 platformu, 8 GPU ile kurumsal AI ve HPC iş yüklerini destekliyor. GB200 NVL72 rafı, 36 GB200 Süperçip ile toplamda 72 GPU ve 36 CPU içeriyor. Exascale ölçeğinde yapay zekâ modellerini çalıştırıyor.

GB200 NVL72.

Sonuç ve Sektörel Etki

Blackwell B200, trilyon parametreli modellerin eğitimini ve çıkarımını mümkün kılıyor. Ayrıca, veri merkezi tasarımını raf ölçekli ve sıvı soğutmalı mimarilere kaydırıyor. Bu GPU, sağlık, finans, otomotiv ve bilimsel hesaplamalarda derin etkiler yaratıyor. Örneğin, ilaç keşfi ve genomik analiz hızlanıyor. Otonom sürüş sistemleri daha güvenilir hale geliyor. Simülasyon ve robotik projeler gelişiyor.

Sonuç olarak, NVIDIA Blackwell B200 sadece bir GPU değil. Platform, yapay zekâ veri merkezlerinin geleceğini şekillendiriyor. Performans ve yazılım ekosistemini birleştirerek veri merkezlerini dönüştürüyor. Buna ek olarak, yüksek performans ve enerji verimliliği, toplam sahip olma maliyetini düşürüyor.